Manowce umysłu, czyli atrakcyjne bezdroża.

W. Duch, Wstęp do kognitywistyki - spis treści

Psychologia i modele psychoanalityczne, Freud, Jung i inni psychoanalitycy | Fenomenologia i egzystencjalizm | Psychologia humanistyczna i transpersonalna | Metafory wynikające z teorii chaosu | Teoria katastrof | Holograficzna teoria umysłu | Mechanika kwantowa i świadomość | Manowce filozofii | Manowce różnorakie i Polski wkład | Podsumowanie

Manowce intelektualne to liczne pomysły, które wywołały początkowo wielki entuzjazm, ale nie osiągnęły swoich celów i nie doprowadziły do głębszego rozumienia. Nie są to jednak pomysły pseudonaukowe, jak w poprzedniej części, ale autentycznie pomysły naukowców.

Niektóre wywarły duży wpływ na rozwój nauki czy kultury i w dalszym ciągu są rozwijane, mają nadal swoich zwolenników. Jednak nie należą do głównego nurtu nauki, zawiodły pokładane w nich nadzieje i dzisiaj już nie są w centrum zainteresowania. Chociaż zaprowadziły nas na bezdroża nadal w popularnych opracowaniach często prezentowane są jako rewelacje.

Jeśli przez wiele lat nie widać postępu, to nie należy go szybko oczekiwać ... nie ma co liczyć na złąpanie Yeti, Nessi czy UFO. Najwyraźniej pewne dziedziny znalazły się na peryferiach nauki, błądzą po manowcach, gdzie niewiele da się odkryć. Tak się stało w przypadku parapsychologii, psychotroniki czy innych paranauk. Niektóre pomysły mają jednak szansę odżyć po latach, więc wybór teorii, które zeszły na manowce jest ryzykowny.

Wspólną cechą wielu teorii, które zeszły na manowce jest:

- traktowanie umysłu jako niezgłębionej tajemnicy (świadomości nie da się zrozumieć);

- doszukiwanie się w nim pierwiastków niepojętych (nieobliczalność u R. Penrose'a, nadzwyczajne moce przyczynowe neuronów u J. Searla);

- teorie mijające się z rzeczywistością, czyniące różne dziwne założenia nie dające się zweryfikować;

- mgliste cele badawcze zmierzające do odpowiedzi na pytania pozorne, nie mające nic wspólnego z rzeczywistymi problemami nauk o poznaniu;

- teorie nie odnoszące się do konkretnych faktów, tylko do niejednoznacznie określonych pojęć, "wyjaśniające" świadomość, umysł, sens życia;

- teorie oparte na złudnej nadziei zrozumienia umysłu jak monolitu zamiast zbioru złożonych procesów;

- teorie mieszające idee religijne z naukowymi, mające odpowiedź na wszystko, ale nie przewidujące niczego konkretnego;

- teorie doszukujące się w mózgu efektów kwantowych, występujących na poziomie cząstek elementarnych.

Jeśli teoria wymaga 10 kroków rozumowania a prawdopodobieństwo prawdziwości każdego z nich wynosi 50% to prawdopodobieństwo jej prawdziwości wynosi tylko 0.510=0.0001, czyli 0.01%.

Znani eksperci w swojej dziedzinie często przyjmują naiwny punkt widzenia w gałęziach nauki, w których nie mają kompetencji.

Zdarza się też, że eksperci w jakiejś dziedzinie zaczynają głosić poglądy całkiem odbiegające od powszechnie przyjętych. Czasami mają rację i dostają nagrodę Nobla ... ale znacznie częściej się mylą.

M.01. Psychologia i modele psychoanalityczne

Psychoanaliza wywarła ogromny wpływ na psychologię i kulturę w XX wieku. Została jednak wyparta z uniwersytetów i prawie wszędzie traktowana jest jedynie jako ciekawostka historyczna.

Informacje przetwarzane są przez mózg w sposób równoległy, z czego nie zdajemy sobie sprawy. Tylko niewielka część aktywacji mózgu staje się treścią świadomości, zwyciężając w konkurencji z innymi i stając się na tyle silna, by było ją można odróżnić od neuronalnego szumu, a więc łatwo zinterpretować - jakie to procesy?

Już Witelon w XIII wieku badał złudzenia wzrokowe i pisał wyobrażeniach demonów jako kulturowo uwarunkowanych złudzeniach psychologicznych.

Psycholodzy w XIX wieku

skupili się początkowo na introspekcyjnym badaniu

świadomości

(szkoła Wundta psychologii holistycznej).

Prekursorzy badań procesów nieświadomych

zostali już omówieni: był to magnetyzm zwierzęcy Franza Mesmera, jego wpływ na Johna Elliotsona i leczenie za pomocą transów, oraz neurohipnotyczne wyjaśnienia Johna Braida.

Strefą między świadomością a prostymi automatyzmami zawiązanymi z badaniem czynności odruchowych zajmowali się

angielscy neurolodzy, Benjamin Carpenter i Thomas Laycock.

Istotny był też wpływ szkockiego filozofa

Sir Williama Hamiltona:

"Treść naszej świadomości jest zbudowana z tego, czego poznać nie możemy".

Hamilton przypisywał tę ideę Leibnizowi.

Jeszcze w połowie XIX wieku usiłowano wyznaczyć obszar właściwy działaniu duszy, początkowo jako funkcje mózgowe w odróżnieniu od rdzeniowych, a potem jako coraz mniejszą część funkcji mózgowych, ostatnio głównie funkcje decyzyjne, ale i te udało się w końcu zrozumieć w szczegółach.

Zauważenie wpływu procesów nieświadomych było dla

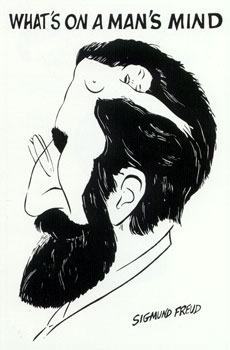

Freuda olśnieniem, chociaż przez nim wielu ludzi pisało o nieświadomych czynnikach wpływających na zachowanie.

Z Josefem Breuerem

opublikował w 1895 roku "Studia nad histerią", w których napisali: "Człowiek chory na histerię cierpi w znacznej mierze na wspomnienia".

Świadomie przetwarzamy niewiele informacji, procesy motoryczne i poznawcze zachodzące w któtkim czasie są bardziej efektywnie bez jej udziału, świadomość bardziej przeszkadza niż pomaga w szybkim reagowaniu.

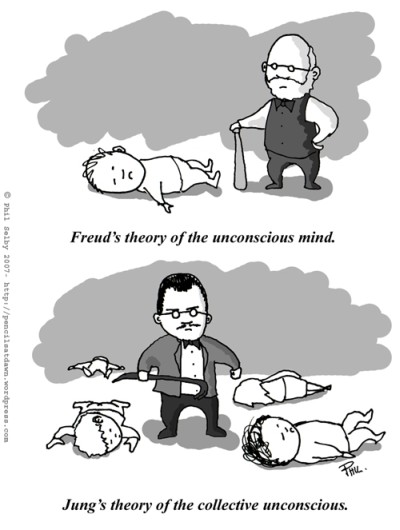

Nieświadomość u Freuda przechowuje wspomnienia, instynktowne pragnienia i potrzeby, działa filtrująco kontrolując dostęp informacji do świadomości.

Na granicy świadomości są wspomnienia i popędy stłumione, czyli

przedświadome.

Ponieważ nieświadome emocje, uczucia i wyobrażenia (ślady pamięci o "ładunku energetycznym") są niewidoczne, a Freud zajmował się pacjentami cierpiącymi na neurozy, uznał nieświadomość za ciemne siły wypierające szkodliwe myśli i wywołujące neurozy.

Badaniem tych sił zajęła się

psychologia głębi.

W psychologii głębi psyche jest częściowo świadomym i częściowo nieświadomym procesem.

Część nieświadoma zawiera wyparte i stłumione doświadczenia i osobiste problemy i nawyki, a jeszcze głębiej elementy kolektywne, archetypowe, transpersonalne, odpowiedzialne za mityczno-religijny symbolizm.

Można w niej obecnie wyróżnić 3 perspektywy teoretyczne:

- Psychoanalityczny, związany pierwotnie z Freudem, który rozwinął się w kierunku terapii dziecięcej, teorii relacji z obiektem, np. relacji matka-dziecko ( Melanie Klein, Donald Winnicott, Margaret Mahler), obecnie w znacznej mierze zastąpiony przez psychologię rozwojową i teorię rozwoju umysłu.

- Psychologia indywidualna Alfreda Adlera, skupiająca się na procesach rozwojowych od wczesnego dzieciństwa.

- Psychologia analityczna Carla Gustawa Junga, opierająca się na pojęciach nieświadomości zbiorowej, synchroniczności, oraz archetypów.

Idee Junga są szczególnie popularne w kręgach new age i środowiskach parareligijnych. Nieświadomość zbiorowa zawiera podstawowe instynkty i schematy myślenia, zachowania, sposobu "bycia w świecie" człowieka.

Jung uważał nieświadomość zbiorową za źródło snów proroczych, wiązał ją z ezoterycznymi doktrynami tantry, lamaizmu, jogi kundalini i taoistycznej, sam miał stany schizofreniczne i depresyjne, ale przeszedł proces rozwoju własne osobowości, który nazywał

indywiduacją, polegający na integracji elementów nieświadomych dzięki analizie snów i innym technikom.

Nieświadomość zbiorowa może być odbiciem ogólnego podobieństwa struktur mózgów wszystkich ludzi, charakterystycznych cech gatunku związanych z działaniem układu limbicznego; w takim sensie nie ma jednak wiele wspólnego z poglądami Junga.

Synchroniczność ma być zasadą nieprzyczynowego związku pomiędzy zdarzeniami.

Pojęciem tym interesował się

Wolfgang Pauli, jeden z najwybitniejszych fizyków XX wieku.

Synchroniczność ma działać obok zasady przyczynowości prowadząc do wyjaśnienia zbiegów okoliczności, które są wyrazem wszechzwiązku zdarzeń, w tym stanów psychicznych z równoczesnymi zdarzeniami fizycznymi.

Jung używał tego pojęcia do uzasadnienia astrologii i zjawisk paranormalnych: jasnowidzenia, telepatii, wróżb.

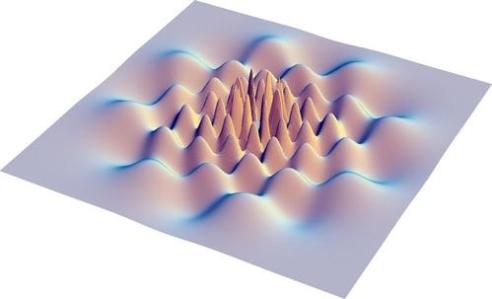

Na poziomie kwantowym istnieją

stany splątane,

których własności przypominają synchroniczność, gdyż wiążą zdarzenia w nieprzyczynowy sposób. Nie można co prawda za pomocą stanów splątanych przesyłać informacji, ale też nie można uznać, że wyniki pomiarów dla odległych od siebie cząsteczek splątanych są od siebie niezależne. Nie wykryto jednak stanów splątanych w złożonych strukturach komórkowych w temperaturze pokojowej, chociaż efekty splątania na poziomie subkomórkowym być może wpływają na orientację ptaków za pomocą ziemskiego pola magnetycznego (por. rozdział o mechanice kwantowej poniżej).

Archetyp to nieświadomy praobraz, wyrażający się w postaci symbolicznej formuły, wyraziste skłonności do specyficznych instynktownych reakcji.

Archetypy "narzucają się wszystkim wrażeniom", niosą ładunek emocjonalny, powtarzają się w doświadczeniach wielu pokoleń.

Archetypy są związane z ważnymi zdarzeniami w życiu ludzi, takimi jak narodziny, odrodzenie, śmierć, poczucie mocy, jedności.

Można wyróżnić archetyp bohatera, dziecka, Boga, demona, zwierzęcia, archetyp wody (życia) czy ognia (symbol wypalenia, oczyszczenia).

Josepha Campbell, wybitny mitograf i antropolog XX wieku, uznał wspólne cechy mitów w różnych kulturach świata za dowód istnienia archetypów.

Psychologia archetypów Jamesa Hillmana (ucznia Junga) zwróciła się jeszcze bardziej w stronę filozofii i religii, od Platona, Plotyna, i neoplatonizmu, poszukując duszy świata (anima mundi), jak i odwołując się w bardzo mglisty sposób pojęcia duszy, np. pisząc, że jest to „nieznany czynnik, który przemienia zdarzenia w przeżycia i umożliwia doświadczenie miłości”.

Czym jest nieświadomość i przedświadomość?

Zachowanie wynika z neurodynamiki procesów zachodzących w mózgu. Być może pewne idee Freuda dadzą się powiązać bardziej precyzyjnie z procesami neurodynamiki niż tylko na ogólnym poziomie relacji id, ego i superego do pnia mózgu, układu limbicznego i kory mózgu. Jest tu szansa na rozwój, ale główny nurt badań wywodzących się z psychoanalizy zszedł na manowce, odrywając się od dobrze uzasadnionych teorii wynikających z neuronoauk.

Szanse na lepsze zrozumienie procesów warunkujących nasze zachowanie daje konektomika i badanie procesów neurodynamicznych, które zależą zarówno od konektomu, jak i własności samych neuronów, komórek glejowych, układu krwionośnego, decydując o pojawieniu się specyficznych aktywacji i funkcjonalnych połączeń decydujących o skojarzeniach, pamięci, nawykach czy skłonnościach do charakterystycznych dla danej osoby zachowań. Ogólna funkcjonalna struktura mózgu może sprzyjać utrwaleniu się pewnych archetypów, form myślenia podobnych w wielu kulturach. Pozwala też na utrwalanie się obyczajów, rozwój kultury i stosunkowo bardziej ulotnych memów, łatwo zapamiętywalnych infromacji.

Czy istnieją w mózgu jakieś formy kompleksów i innych zachowań opisywanych przez Freuda, jako przybliżenie do częstych form zaburzeń neurodynamiki? Na razie nie udało się niczego takiego udowodnić, podejście Freuda opierało się na spekulacjach a nie na systematycznych eksperymentach weryfikujących jego hipotezy.

Jak oceniać psychoanalizę i psychologię głębi, na czym polega postęp w tej dziedzinie?

Freud uważał schizofrenię za zaburzenie nieświadomości spowodowane ukrytym homoseksualizmem, tłumacząc brak postępów w leczeniu oporami takich pacjentów.

Późniejszy psychoanalitycy (np. Frieda Fromm-Reichmann) uznali za przyczynę schizofrenii nadopiekuńcze matki, pisząc o "schizofrenikogenicznych matkach".

Zimne matki na przemian z przymusem sadzania na nocnik miały być też winne autyzmowi.

Niestety są to czyste spekulacje, nie zasługujące na miano teorii gdyż w błędny sposób dokonują konceptualizacji wybranych obserwacji nie próbując weryfikować stawianych hipotez.

Czy psychoanaliza to metoda terapii, forma edukacji, droga do lepszego zrozumienia swoich potrzeb? Są lepsze metody, oparte na zrozumieniu procesów

neuroplastyczności mózgu.

Nick Chatter napisał książkę "The Mind is flat. The Illusion of Mental Depth and the Improvised Mind" (Penguin Books 2018), w której argumentuje, że umysł nie ma żadnej głębi, ale tworzy na życzenie z fragmentów różne kombinacje, którym nadajemy narracyjny sens. Opisuje szczegółowo jeden z przypadków badanych przez Freuda, Herberta Grafa, słynnego dyrektora opery Wiedeńskiej. Herbert w wieku 4 lat był świadkiem wypadku powozu, koń leżąc na oku rozpaczliwie wierzgał. Od tego czasu zaczął się bać koni, rozwinęła się u niego fobia. Dyskutując z Freudem Max Graf, ojciec Herberta, doszli wspólnie do wniosku, że przyczyna fobii jest strach przed dużym penisem i czułością matki, kompleks Edypa, rzekomo powodujący, że mały Herbert bał się ojca i rywalizował z nim o względy matki.

Jako droga do zrozumienia umysłu modele psychoanalityczne nie spełniły pokładanych w nich nadziei, jednak jakieś powiązania z neuronaukami są możliwe.

Psychoanalizę jako terapię zajmują inne formy

psychoterapii, chociaż jest to dziedzina nadal pełna kontrowersji.

Psychoanalizę jako gałąź nauki zastępuje psychologia rozwojowa, neuronauki społeczne, psychiatria, neuropsychologia i pokrewne dziedziny.

Niektórzy badacze usiłują łączyć neuronauki z perspektywą psychoanalityczną, określając to jako neuropsychoanalizę.

W szczególności od 1999 roku istnieje czasopismo

"Neuropsychoanalysis"

i Stwowarzyszenie Neuropsychoanalizy.

Zrozumienie ogólnych mechanizmów myślenia może oczywiście pokazać, że u podstaw pojęć i wyobrażeń wielu kultur leżą podobne skojarzenia, siatka pojęciowa do pewnego stopnia jest oparta na biologicznych podstawach. Neuropsychoanalitycy nie kwestionują neurobiologicznych podstaw działania umysłu. Próbują je powiązać z modelami psychoanalitycznymi, wyjaśnić złożone przyczyny zachowania, a to jest znacznie trudniejsze do badania niż proste eksperymenty rozpowszechnione w neuronaukach.

W szczególności memetyka

była krokiem w kierunku zrozumienia procesu zapamiętywania, tworzenia się sieci pojęć i modeli świata, powstawania powtarzalnych, silnych pobudzeń w sieciach neuronalnych. Takie procesy na wczesnym etapie rozwoju ujawniają się później jako nieświadome skojarzenia i mają wpływ na nasze myślenie.

Konfabulacje, wiara w cuda czy inne nieracjonalne przekonania mogą mieć jednak silny wpływ na zachowanie. Z subiektywnego, wewnętrznego punktu widzenia nasze myśli, emocjonalne reakcje nie odnoszą się do jakiejś obiektywnej rzeczywistości, tylko wewnętrznego modelu świata. Cierpienie czy radość to subiektywne przeżycia na które psychoterapia może mieć istotny wpływ. Stąd udane próby połączenia różnych form psychoterapii z leczeniem farmakologicznym zaburzeń psychicznych.

Nasze zachowanie nie da się zwerbalizować i opisać w logiczny, narracyjny sposób.

Zauważył to już Błażej Pascal w 1669 roku pisząc "Serce ma swoje racje, których rozum nie zna". Jednakże utworzenie sobie pewnego modelu sytuacji, wyobrażenie tej sytuacji, zmienia skojarzenia ze stanami lekowymi, kanalizując je w specyficzny sposób i pozwalając uwolnić się od lęków.

M.02. Psychologia humanistyczna i transpersonalna

Psychologia humanistyczna w latach 50. stała się obok psychoanalizy i behawioryzmu trzecią siłą w psychologii, pismo Journal of Humanistic Psychology wydawane jest od 1961 roku, mamy też

Polskie Towarzystwo Psychologii Humanistycznej.

Do tego czasu psychologia interesowała się głównie psychopatologią lub prostymi formami zachowania (odruchami) i uczenia.

Psychologia humanistyczna zajęła się bardziej złożonymi funkcjami i aspiracjami ludzi psychicznie zdrowych: kreatywnością, autonomią, osobowością i poczuciem tożsamości, odpowiedzialności, obiektywizmu czy zdolnością do altruizmu i miłości.

Zakładano, że człowiek jest z natury dobry, zdolny do empatii, chce stać się lepszym, realizować swój potencjału rozwojowy, być kreatywny, aktywny, jest niepowtarzalną jednostką której subiektywna percepcja i rozumienia świata ma wielką wartość.

Badania miały się koncentrować na relacji nadawca-komunikat-odbiorca w aspekcie holistycznym, uwzględniając i próbując zrozumieć perspektywę badanej osoby.

Nadrzędną potrzebą człowieka jest samoaktualizacja, a celem pełny rozwój jego możliwości, nie zawsze społecznie akceptowalny.

Mamy tu znowu dylemat stabilności i plastyczności: kryteria zewnętrzne sprzyjają stabilności społecznej i zewnętrznemu sterowaniu zachowaniem, a wewnętrzne kryteria samorealizacji wolności i rozwojowi indywidualnemu, sterowaniu wewnętrznemu.

Zablokowanie możliwości rozwoju prowadzi do psychopatologii, psychika i cały organizm muszą być harmonijną całością, pełną osobą.

Nie cel, ale droga jest najważniejsza bo kształtuje twórcę.

Psychologia humanistyczna podkreślała potrzebę bycia tu i teraz, skupienie się na aktualnym doświadczeniu.

Akty przemocy uważała za działania wbrew naturze, niezgodne z harmonią.

Psychologia transpersonalna poszła jeszcze krok dalej, zajmując się stanami umysłu wykraczającymi poza naszą "persona".

W 1969 roku zaczęto wydawać Journal of Transpersonal Psychology (Abraham Maslow, Stanislav Grof, Anthony Sutich) i kierunek ten uznany został za czwartą siłę w psychologii, uwzględniającą wszystkie doświadczenia ludzkie, zajmującą się doświadczeniami granicznymi, w tym również stanami mistycznymi i transcendentalnymi.

Kluczowe tematy to odmienne stany świadomości, rozwój potencjału ludzkiego, przeżycia przekraczające ego, jednostkową jaźń, doświadczenia duchowe.

Obejmuje to badanie przyczyn, efektów i korelatów odmiennych stanów świadomości i przeżyć transpersonalnych jak i metod do nich prowadzących.

Abraham Maslow uznawany był za jednego z najważniejszych psychologów XX wieku.

Opracował piramidę potrzeb ludzkich (piramida Maslowa, 1943 rok), od najbardziej istotnych potrzeb podstawowych do najwyższych potrzeb, które ujawniają się dopiero po spełnieniu potrzeb niższych. Potrzeby te nie są nigdy w pełni zaspokojone a motywacją działania człowieka jest potrzeba ich zaspokojenia.

- fizjologiczne: pożywienie, sen, oddychanie, potrzeby seksualne, dominują nad innymi potrzebami;

- bezpieczeństwa fizycznego i psychicznego;

- przynależności do grupy, bliskich stosunków intymnych, wsparcia, przyjaźni;

- potrzeba uznania, szacunku, poczucie własnej wartości, statusu społecznego, sławy, pragnienie potęgi i dominacji;

- samorealizacji: wyrażają się w dążeniu człowieka do rozwoju swoich możliwości poznawczych (wiedzy, rozumienia, ciekawości) jak i estetycznych (harmonii i piękna).

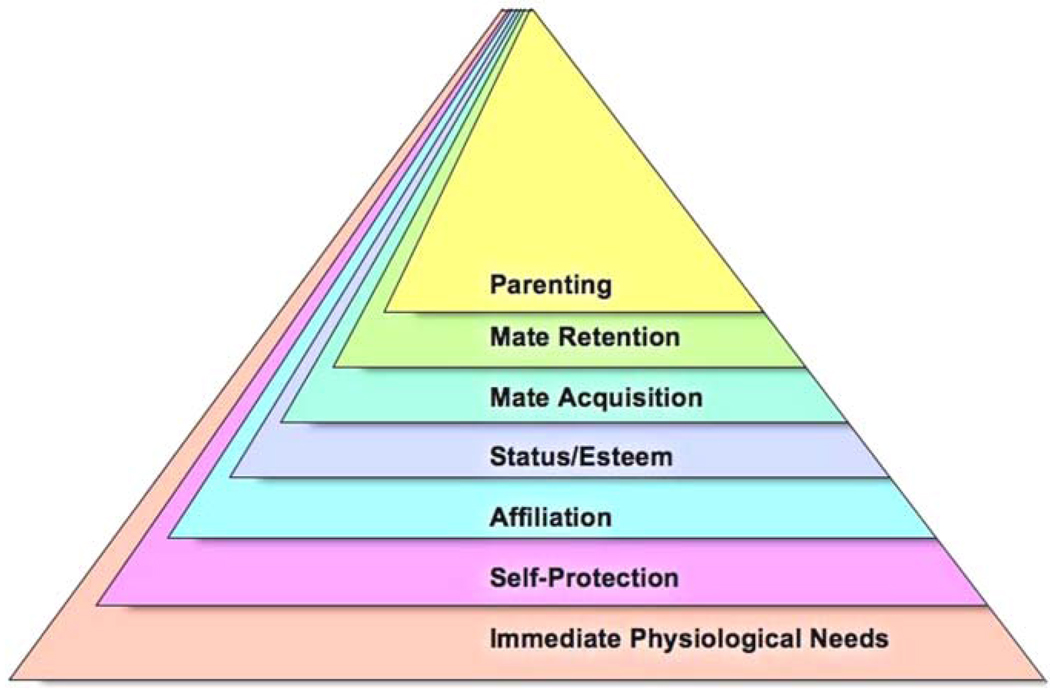

Nowsza wersja piramidy Maslowa odwołuje się do psychologii ewolucyjnej i nie zakłada ścisłej hierarchii, poziomy nakrywają się, realizacja jest jednoczesna.

Dodano do niej potrzeby związane z szukaniem partnera, utrzymaniem związku i wychownaiem potomstwa.

Maslow zbierał wiele danych opisujących przeżycia osób, które osiągnęły szczyt piramidy rozwoju i zauważył, że towarzyszyły temu często przeżycia transpersonalne, poczucie uniwersalnej jedności przekraczające jednostkowe "ja".

Teoria Z Maslowa oparta na jego hierarchii potrzeb ma całkiem praktyczne zastosowanie w zarządzaniu, szczególnie w gospodarce japońskiej: jak postępować by pracownicy byli szczęśliwi a firma rozkwitała?

Najbardziej popularnym przedstawicielem psychologii transpersonalnej jest

Ken Wilber.

Napisał wiele książek, po polsku jest cała

"Biblioteczka Wilberowska"

(Wyd. J. Santorski).

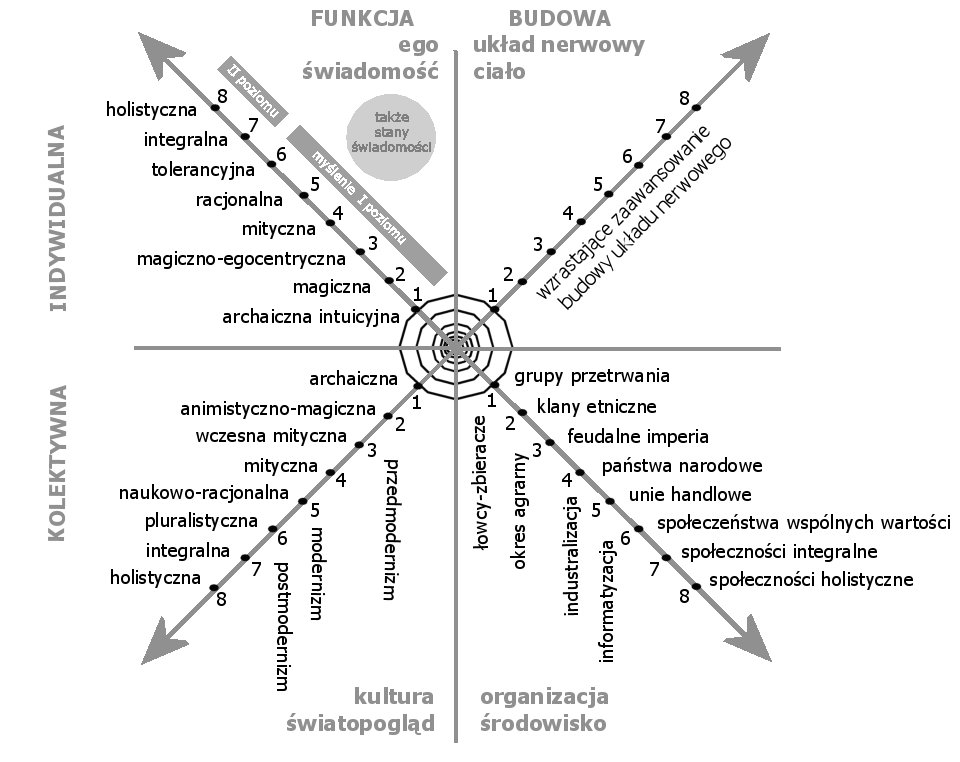

Wilber zajmował się świadomością próbując opracować "spektrum świadomości", uwzględniające możliwe jej stany, włączając stany transpersonalne.

Psychopatologia świadomości omówiona została w jego jedynej książce mającej naukowe ambicje, "Transformations of Consciousness: Conventional and Contemplative Perspectives on Development" napisanej z dwoma psychologami (Jack Engler, Daniel Brown) w 1986 roku, i wydanej przez Shambhala Publications.

"Małżeństwo rozumu z duszą" (2008) omawia relacje między nauką i religią.

Z obwoluty: "Ken Wilber, jeden z najważniejszych filozofów naszych czasów, z olśniewającą jasnością pokazuje, jak moglibyśmy zacząć myśleć o nauce i religii, żeby połączyć duchowy, subiektywny świat starożytnej mądrości z obiektywnym, empirycznym światem współczesnej wiedzy".

Czy jest to udana próba? Są to zagadnienia bardzo trudne i można się tu bawić w liczne spekulacje, niektóre z nich zawierają ciekawe spostrzeżenia ale ... Nauki poznawcze, w tym badania nad mózgiem są przez Wilbera całkowicie ignorowane.

Przekonanie, że z faktu podobnych wrażeń w stanach głębokiego skupienia osiąganych w różnych tradycjach kontemplacyjnych wynika fizyczne istnienie innych poziomów rzeczywistości jest równie prawdziwe, jak przekonanie, że z tego, iż po naciśnięciu zamkniętych powiek palcami każdy widzi rozbłyski wynika, że istnieje przestrzeń wewnętrzna umysłu pełna gwiazd.

Niezależnie od kultury, w której się wychowaliśmy, mamy podobnie zbudowane mózgi, odczuwamy podobne emocje, a stany głębokiej kontemplacji prowadzą do podobnych stanów mentalnych.

Nie można stąd jednak wnioskować, że jest to sposób na odkrycie innych wymiarów "translogicznej" rzeczywistości; znacznie bardziej prawdopodobne wyjaśnienie to biologiczne podobieństwo mózgów, które zdolne są do przyjmowania podobnych stanów. Praktyka kontemplacji może doprowadzić do przemiany wewnętrznej, zmienić nasz sposób patrzenia na świat, ale nie pomoże nam stworzyć nowej, dającej się zweryfikować eksperymentalnie hipotezy na temat natury świadomości czy struktury osobowości.

Wg. Wilbera nauka jest "monologiczna", bo opisuje zjawiska, nie angażując się w dialog.

Badania doświadczalne zawsze są dialogiem z Naturą, wymyślamy kolejne pytania, by rozstrzygnąć prawdziwość hipotez, a potem robimy eksperymenty by poznać odpowiedź Natury na te pytania.

W pismach naukowych idee Wilbera nie są dyskutowane.

Podobne uwagi można zastosować do popularnych prac Stanislava Groffa.

Nauka opiera się na tworzeniu hipotez i próbie ich podważenia, próbuje weryfikować każdy krok. Groff i Wilber tylko tworzą hipotezy, a to wyraźna oznaka, że zmierzają na manowce.

Mózg jest według nich tylko odbiornikiem dla umysłu; coraz lepiej rozumiemy jednak, jak procesy zachodzące w mózgu odpowiadają za nasze decyzje, jak dzięki specyficznym sposobom przepływu informacji pojawiają się złożone funkcje. Dokładniejsza

krytyka takiej hipotezy jest tu.

Robiąc modele komputerowe tych procesów nie tworzymy żadnego odbiornika, tylko je wyjaśniamy.

Czy decyzje podejmowane przez jakiś niematerialny umysł, pojawiające się znikąd by wpłynąć na mój mózgi cały organizm, mogę nazwać moimi? Dlaczego się pojawiają takie a nie inne myśli? Co taki niematerialny umysł miałby ze mną wspólnego? Jedynie utożsamiając się z całym swoim organizmem, przede wszystkim z mózgiem, mogę zrozumieć czym jest umysł i czym jest "ja".

Groff rezygnuje w istocie z wszelkich wyjaśnień, a to nie jest postawa naukowa.

Teorie osobowości

i charakteru, wyższych struktur psychiki, są ciekawe ale tu również trudno jest o oddzielenie spekulacji od rzeczywistości.

Z psychologii humanistycznej i transpersonalnej wywodzi się ciekawy nurt

psychologii pozytywnej. Jest to szybko rozwijająca się dziedzina psychologii, która zajmuje się subiektywnym poczuciem dobrostanu (well being), cnotami ludzkimi, męstwem, poczuciem szczęścia.

M.03. Fenomenologia i egzystencjalizm

Fenomenologia była nurtem filozofii mającym badać samą istotę zjawisk, aktów świadomości, opisywać i oglądać to, co jest dane bezpośrednio.

Więcej na ten temat będzie przy omawianiu

neurofilozofii.

Egzystencjalizm

zaczął się jako nurt filozoficzny i literacki, ale przeniknął do psychologii.

Egzystencjalizm bada losy "skazanej na wolność" i odpowiedzialność jednostki,

co stwarza poczucie lęku, beznadziejności, osamotnienia, pesymizmu, zainteresowania problemami przemijania świata i problemami metafizycznymi.

Zwracano uwagę na niepowtarzalność każdej jednostki, unikalny światopogląd, perspektywę wewnętrzną, problemy odpowiedzialności i wyboru, tożsamości i autonomii.

Prawdopodobnie większość dzieł egzystencjalistów była wynikiem depresji.

Chociaż nie są to nurty ściśle naukowe miały na celu lepsze zrozumienie natury ludzkiej, zwróciły uwagę na szereg wcześniej ignorowanych aspektów w psychologii, ale do postępu nauki nie doprowadziły.

W książce:

Describing Inner Experience? Proponent Meets Skeptic (MIT Press 2007),

Russell Hurlburt i Eric Schwitzgebel próbowali zastosować podejście fenomenologiczne do opisu doświadczenia wewnętrznego, czyli świadomości fenomenalnej.

Co o sobie wiemy? Czy potrafimy to opisać? Hurlbrut był przekonany, że jest to możliwe, Schwitzgebel był sceptyczny.

Melanie miała za zadanie szczegółowo opisać treść swojego umysłu w przypadkowym momencie gdy zapikał alarm, a obaj autorzy zadawać pytania i analizować jej opisy.

Czy można opisać swoje doświadczenie i czy można będzie to wiarygodny opis?

Spróbujcie sami!

Wynikiem rozważań egzystencjalnych są liczne formy

psychoterapii egzystencjalnej, odwołujące się do uniwersalnych zachowań niezależnych od kultury, na płaszczyźnie fizycznej, społecznej, psychologicznej i duchowej.

Meta-analiza skuteczności

tych terapii nie pozwala na wyciągnięcie jednoznacznych wniosków. Podobnie jak w przypadku innych form psychoterapii konieczna jest bardziej precyzyjna identyfikacja populacji, dla której specyficzna forma terapii może przynieść korzyści.

Egzystencjalna psychologia eksperymentalna

(experimental existential psychology)

jest nowym paradygmatem badań psychologicznych, odwołującym się do

teorii opanowywania trwogi (ang. terror management theory – TMT). Świadomość nieuchronności śmierci jest tu uznawana za podstawowy egzystencjalny lęk, a samoocena odwołująca się do kultury, światopoglądu, jest ochroną przed tym lękiem. Dlatego ludzie tak bronią swojego światopoglądu, bo pozwala to im ukryć głębokie lęki. Inne głębokie lęki egzystencjalne związane są z izolacją, ostracyzmem społecznym, samotnością; zniewoleniem, ograniczeniem wolności; utratą poczucia sensu swojej egzystencji. Te lęki opisali w swoich książkach E. Fromm, M. Heidegger, S. Kirkegaard, J.P. Sartre, R. May, V. Frankl, M. Buber i inni autorzy.

M.04. Metafory wynikające z teorii chaosu

Teoria chaosu

wiąże się też z teorią

systemów złożonych. Proste zasady wielokrotnie stosowane prowadzą do powstania skomplikowanych struktur i zachowań, których działania nie da się przewidzieć. Najlepszym przykładem jest nieskończona złożoność

zbioru Mandelbrota,

powstająca z iterowania funkcji zespolonej z= z2+c. Można to zobaczyć robiąc

zoom 1099 razy w okolicach jednego z punktów tego zbioru.

Mózg jest bez wątpienia układem nadzwyczaj złożonym. Neurony można traktować jako proste, oddziałujące ze sobą elementy (chociaż są w rzeczywistości niezwykle skomplikowanymi komórkami).

Dotychczas nauka badała układy stosunkowo proste i nie było wielu doświadczeń z matematycznymi modelami układów złożonymi. Eksperymenty komputerowe pokazały, że pomimo prostych elementów i oddziaływań pomiędzy nimi powstają złożone zjawiska jakościowo różne niż w układach prostych.

Pojawiły się koncepcje

emergentyzmu,

głoszące wyłanianie się nowych jakości w układach złożonych z wielkiej liczby oddziaływujących ze sobą elementów.

Modele te pojawiły się dopiero przy końcu lat 1980. i stanowią cenne narzędzie do badania układów dynamicznych, w tym również modeli neuronów i ich sieci.

Nie ma jednak powodu by sądzić, że proste układy chaotyczne pozwolą stworzyć dobre modele umysłu.

Modele uwzględniające chaos jako graniczny stan neurodynamiki pokazują, że dzięki temu możliwy jest bardziej efektywny proces eksploracji różnych stanów mózgu, szukania nowych spójnych konfiguracji pobudzeń, skojarzeń.

Zjawiska "na krawędzi chaosu", a więc pomiędzy regularnym, przewidywalnym zachowaniem, a zachowaniem chaotycznym, nieprzewidywalnym, są ciekawym obszarem badań, ale nie doprowadziło to do rewolucji w naszym rozumieniu procesów zachodzących w mózgu.

Teoria chaosu jest bardzo przydatna do opisu układów dynamicznych o niewielkie liczbie zmiennych, mózg ma takich parametrów koniecznych do opisu bardzo dużo. Struktura mózgów rożnych osób jest do siebie dość podobna (w obrębie jednego gatunku a nawet pomiędzy niektórymi gatunkami). Dotyczy to ogólnego podziału na zakręty i bruzdy kory, na podkorowe jądra. Ten ogólny schemat zakodowany jest w genach. Jednakże bliższe przyjrzenie się szczegółom budowy np. kolumny korowej (średnica ułamka milimetra i wysokość 2-4 mm, kilkadziesiąt tysięcy neuronów) pokazuje wielkie zróżnicowanie typów neuronów i połączeń miedzy nimi, różnych mikroobwodów. Złożoność struktur jest zbyt wielka by dało się ją kontrolować za pomocą genów.

Rola zjawisk chaotycznych w układzie nerwowym jest nadal dyskutowana. Metafory teorii chaosu i układów złożonych mogą być przydatne do jakościowego zrozumienia zachowania.

Trzeba jednak uważać by zbyt uproszczony język metafor wywodzących się z teorii chaosu nie stworzył wrażenia, że taki opis wystarczy do zrozumienia procesów neurodynamicznych zachodzących w mózgu.

Nadzieje na prostą, matematyczną teorię umysłu są bezpodstawne.

M.05. Teoria katastrof

Teoria katastrof elementarnych rozwinięta przez Rene Thoma w latach 1960-70, wydawała się dobra do wyjaśnienia wszystkiego.

Są to nieliniowe modele zachowania w odpowiedzi na różne bodźce.

Teoria katastrof zastosowana została w wielu praktycznych modelach przez Christopher'a Zeemana i innych matematyków.

Ponieważ wiele naszych zachowań posiada nieciągłości można przy pomocy katastrof jakościowo modelować proste zjawiska psychiczne.

Najczęściej stosowano najprostszą z katastrof, fałdę.

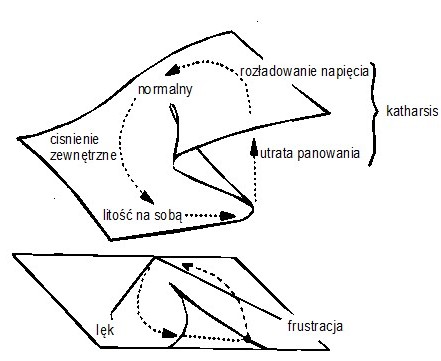

Przykładem takiego zastosowania może być opis zachowania człowieka jako gry id i superego w teorii Freuda.

Wiele modeli psychologicznych da się w ten sposób opisać, ale czy to je jakoś potwierdza? Czy

da się zrobić model bardziej złożonych zachowań człowieka w oparciu o bardziej skomplikowane topologicznie powierzchnie zachowań?

Nie tylko przestrzeń parametrów musiałaby być dużo bardziej skomplikowana ale i przestrzeń zachowań wielowymiarowa.

Pomysł jest fascynujący ale poza katastrofę typu „motyl” nikt dotychczas nie wyszedł (mamy w niej 3 parametry kontrolne plus jeden oznaczający zachowanie) więc jest to chyba bardzo trudne.

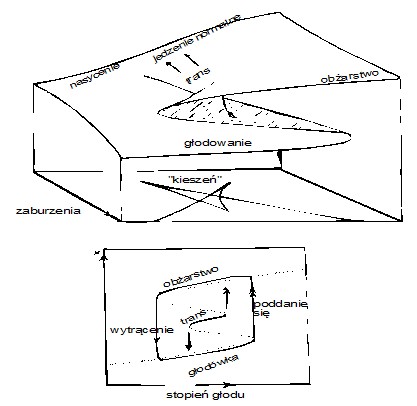

Katastrofa typu „motyl” została zastosowana z powodzeniem do opisu choroby psychicznej anorexia nervosa.

Teoria katastrof nie odniosła wielkiego sukcesu, pomimo sformułowania jej i pierwszych interesujących zastosowań w połowie lat 70-tych.

Teoria elementarnych katastrof (jedyna część teorii katastrof, która doczekała się zastosowań) usiłuje opisać przestrzeń zachowań w sposób globalny, przy pomocy jednej funkcji opisać całą przestrzeń zachowań.

W takim ujęciu przestrzeń parametrów, od których te zachowania zależą, nie może być więcej niż 4-wymiarowa, gdyż dla więcej wymiarowych przestrzeni liczba możliwych topologii przestrzeni staje się nieskończona.

Dużo ciekawszym podejściem jest lokalny opis zdarzeń, pozwalający składać dowolnie skomplikowane zachowania przestrzeniach o dowolnej liczbie parametrów.

Opis taki przedstawić można zarówno w języku modeli neuronowych jak i bardziej ogólnym języku układów adaptujących się.

Dlaczego zachowanie miałoby się dać zredukować do kilku prostych nieliniowości i nieciągłości?

Nie oznacza to, że teoria katastrof jest teorią nieprzydatną: z matematycznego punktu widzenia jest ciekawa a w niektórych dziedzinach (np. chemii) może być bardzo przydatna, ale nikomu nie udało się jeszcze zrobić przydatnego modelu bardziej skomplikowanych form zachowania.

M.06. Holograficzna teoria umysłu

Filozofia wieczysta

(philosophia perennis) Leibniza, odwieczne myśli leżące u podstaw wszystkich religii i filozofii, może być pierwowzorem paradygmatu holograficznego gdyż traktuje rzeczywistość jako odbicie rzeczywistości odmiennego typu.

William James

na początku XX wieku sugerował w swojej książce

Rodzaje doświadczeń religijnych, że istnieje rzeczywistość, którą umysł postrzega jedynie fragmentarycznie, przeczuwając w niektórych stanach umysłu jej głębsze podstawy.

Henri Bergson, twórca intuicjonizmu: ostateczna rzeczywistość jest pojmowana jedynie intuicyjnie.

Alfred Whithead, matematyk i filozof, przedstawia

filozofię procesu w której odchodzi od pojęcia substancji i uznaje dualizm materii i umysłu za fałszywy.

Karl Lashley publikuje dane eksperymentalne, z których wynika, że zapamiętane fakty nie są przechowywane w zlokalizowany sposób przez mózg.

Dennis Gabor

opublikował ideę

holografii

w 1947 roku.

Pierwsze hologramy otrzymane zostały w 1965 roku, wkrótce po wynalezieniu lasera.

W końcu lat 60. amerykański neurofizjolog

Karl Pribram

mierzył sygnały w korze wzrokowej małp, oglądających proste obrazy geometryczne.

Oprócz sygnałów bezpośrednich do obserwowanych grup neuronów dochodzą sygnały z innych obszarów pamięci, interferując z sygnałami dochodzącymi z nerwu wzrokowego, czyli widzianymi obrazami.

Pribram doszedł do wniosku, że proces ten najlepiej opisują hologramy (było to wynikiem jego spotkania z D. Gaborem).

Idee holograficzne zawarte zostały w znakomitej książce Pribrama „Languages of the Brain”.

David Bohm wysunął na początku lat 70-tych hipotezę

ukrytego holograficznego porządku świata, spekulując na temat możliwości bezpośredniej percepcji tego porządku.

Pribram połączył idee Bohma ze swoimi rozważając następnie metafizyczne implikacje tej syntezy. Tak narodził się „paradygmat holograficzny”, przyjęty z entuzjazmem przez zwolenników „wieczystej filozofii” jako z dawno oczekiwane naukowe uzasadnienie ich poglądów.

Dlaczego hologramy? Pamięć odtwarza całe sytuacje, uszkodzenia części kory nie niszczą żadnych konkretnych informacji i zapisy pamięciowe wydają się być przechowywane w tym samym obszarze mózgu. Własności hologramów są podobne.

Skonstruowano nawet teorię interferencji fal EEG mającą prowadzić do powstania hologramów w mózgu, teoria nie przyniosła jednak sukcesów i dzisiaj wiemy, że własności pamięci są wynikiem rozproszonej natury połączeń neuronów.

Zamiast interferencji fal i hologramów w

teorii holograficznej

rozważa się stany kooperatywne (neurodynamikę) sieci neuronowych.

Pribram: poświęciłem teorii holograficznej tylko 10% czasu ale wszyscy tylko o tym mówią.

Teoria holograficzna działania umysłu pozostała interesująca metaforą, która może odegrać jeszcze jakąś rolę w przyszłości, chociaż na razie zepchnięta została na boczny tor badań kognitywnych.

M.07. Mechanika kwantowa i świadomość

Spekulacje dotyczące mechaniki kwantowej wywodzą się z trudności interpretacji sensu matematycznego formalizmu, opisującego kwantowe zjawiska. Świat na poziomie mikroskopowym podlega oczywiście prawom fizyki kwantowej, jednak na poziomie dużych cząsteczek czy całych komórek efekty kwantowe są już niewidoczne. Bardzo trudno jest stworzyć takie warunki eksperymentalne, by efekty kwantowe dały się zauważyć, wymaga to zwykle bardzo niskich temperatur.

Biologia molekularna opiera się na oddziaływaniach cząsteczek chemicznych, tworzących wiązania, skomplikowane struktury biologiczne. Tworzenie się wiązań opisuje

chemia kwantowa, stosująca prawa fizyki kwantowej do układów molekularnych.

W szczególności receptory zmysłowe zamieniające fizyczne oddziaływania światła, dźwięku, smaku czy zapachu działają w oparciu o prawa kwantowe. Szczególnie interesującym przypadkiem jest magnetostrykcja, czyli wrażliwość na pole magnetyczne. Sugerowano, że niektóre ptaki wędrowne (np. rudzik zwyczajny, gajówka) oraz karaluchy wyczuwają pole magnetyczne dzięki specyficznym reakcjom biofizycznym indukowanym przez efekty kwantowe, być może wymagające istnienia stanów splątanych par rodników pełniących rolę fotoreceptorów niebieskiego światła, zwanych

kryptochromami.

Orientacja względem linii ziemskiego pola magnetycznego u ptaków zanika w obecności zmiennych pól magnetycznych, które zaburzają oddziaływania par takich rodników.

Nie ma jednak bezpośredniego dowodu na istnienie splątania kwantowego w takich układach (eksperymentalnie bardzo trudno jest stworzyć stany splątane cząsteczek chemicznych, zwykle wymaga to bardzo niskich temperatur), za to jest wiele alternatywnych modeli magnetorecepcji, np.

"model spinowego kompasu".

Fotosyntezę, mutacje DNA i procesy na poziomie synaptycznym neuronów należy opisywać za pomocą mechaniki kwantowej.

Biologia kwantowa

(Jałochowski, 2011, Al-Khalili, McFadden, 2016)

odkrywa procesy interesujące dla biologii molekularnej, w których istotną role pełnią nietrywialne zjawiska kwantowe, zjawiska których nie da się wyjaśnić za pomocą klasycznej fizyki.

Czy to znaczy, że mechanika kwantowa pomoże również wyjaśniać procesy mentalne i przyda się kognitywistyce? Wszelkie oddziaływania cząsteczek chemicznych ze sobą mają charakter kwantowy. Leki psychotropowe, alkohol czy gazy używane w anestezji oddziałują na neurony zmieniając ich sposób komunikacji. Kluczowy jest sposób komunikacji, przepływ informacji w sieci neuronów, który decyduje o naszych możliwościach postrzegania, reagowania, myślenia, świadomości.

Pomimo wielu spekulacji na temat roli mechaniki kwantowej od ponad pół wieku nie ma żadnego eksperymentu wiążącego mechanikę kwantową i świadomość. Nauka robi postępy wyjaśniając nowe zjawiska i weryfikując ich istnienie eksperymentalnie. Nic takiego nie ma tu miejsca, pojawiają się za to liczne pseudonaukowe

"terapie kwantowe".

Nic nie wskazuje na istotną rolę zjawisk kwantowych na poziomie funkcjonowania neuronów (oprócz siatkówki, gdzie pewne procesy można zainicjować pojedynczym kwantem światła). Wysłanie impulsu przez neuron to wynik setek tysięcy zdarzeń na poziomie kwantowym, a czas trwania impulsu rzędu 1 milisekundy jest miliardy razy dłuższy niż czasy reakcji na poziomie cząsteczek.

Modele komputerowe oparte na klasycznej biofizyce szczegółowo przewidują reakcje neuronów w komputerowych symulacjach opisując prądy i napięcia decydujące o polaryzacji błony neuronu i wysłaniu potencjału czynnościowego. Jest to wynikiem uśrednienia ogromnej liczby procesów kwantowych, które można z dużą dokładnością opisać za pomocą klasycznej biofizyki.

Wszystkie obwody scalone działają dzięki zjawiskom kwantowym, ale nie uważamy naszych smartfonów ani komputerów za komputery kwantowe. Jak widać, jest tu problem z terminologią. Kiedy mówimy o kwantowych komputerach lub kwantowych teoriach świadomości odnosimy się do zjawisk, które można opisać tylko za pomocą teorii kwantowych. Kiedy mówimy o kalkulatorze, który wykonuje obliczenia, wystarczą nam algorytmy i bramki logiczne. Kiedy opisujemy procesy aktywacji w mózgu to nie wystarczy, używamy języka układów dynamicznych, równań różniczkowych opisujących ciągłe zmiany potencjałów, stężeń jonów i neurochemicznych molekuł. Odczuwamy wrażenia gdy widać synchronizację aktywności neuronów w sieci, ale do tego wystarczy nam fizyka klasyczna, nie jest konieczny opis kwantowy.

Nie można tworzyć teorii nie wiedząc na jaki ma być temat! Najpierw ustalmy fakty.

Proponenci teorii kwantowych niewiele wiedzą o umyśle ani fenomenologii świadomości - fakty psychologiczne i neurobiologiczne uważają za drugorzędne i się do nich nie odnoszą.

Co wyjaśnia takie stwierdzenie z prac na temat kwantowych podstaw świadomości: Świadomość jest wynikiem kwantowych kanałów chmur elektronów pi w tubulinach (to rodzaj białek) i mikrotubulach mózgu (to konstrukcje w komórkach z tych białek). Równie dobrze można napisać, że świadomość to funkcja niematerialnej duszy, o której nic nie wiemy. Brzmi ładnie, ale jak to się ma do psychologii i introspekcji, co konkretnie wyjaśnia?

Czy stymulacja efektów kwantowych w komórkach przywróci świadomość? Czy udko kurczaka, w którym jest wiele komórek może stać się świadome? Nie każdy uważa to pytanie za absurdalne, zwolennicy panpsychizmu wyobrażają sobie świadomość jako jakąś substancję, jak dawniej flogiston lub eter, przenikający żywe komórki, ale nie wiadomo co to mogłoby oznaczać.

Oczywiście, że by komórki nerwowe działały muszą zachodzić liczne reakcje chemiczne, podlegające prawom kwantowym. Jednakże degeneracja włókien nerwowych, przesyłania impulsów przez długie aksony, powoduje dobrze określone efekty. Przerwanej komunikacji nie zastąpią kwantowe efekty. Mózg musi się pobudzić dzięki bioelektrycznym procesom, rozchodzeniu się aktywacji w specyficznej, niezwykle złożonej strukturze, której uszkodzenia wywołują poważne problemy, od śpiączki po specyficzne afazje. Efekty kwantowe nie pomogą wybudzić pacjenta ze śpiączki ani nie wywołają wrażeń słuchowych czy wzrokowych u osób z uszkodzoną korą zmysłową.

Komputerowe modele odtwarzające sposób przetwarzania sygnałów przez mózgi pokazują za to coraz bardziej przypominające nasze doznania efekty. Dotyczy to wielu iluzji wzrokowych i słuchowych. Na poziomie percepcji i powstawania myśli efekty kwantowe są zupełnie niewidoczne, podobnie jak nie widzimy reakcji chemicznych czy wirusów, atakujących nasz organizm. Sąto procesy zachodzące w zupełnie innej skali czasowej i przestrzennej.

Jedną z ostatnich prób uzasadnienia kartezjańskiego dualizmu podjął

John Eccles

(1903-1997), laureat nagrody Nobla z fizjologii i medycyny (1963).

Z Karlem Popperem napisał książkę “Mózg i Jaźń” (1977),

samodzielnie książkę “Jak Jaźń kontroluje swój mózg” (1994).

Stawiają w niej hipotezę: umysł wpływa na działanie mózgu przez modyfikacje prawdopodobieństw pobudzeń neuronów na poziomie kwantowym.

Henry Stapp (Berkeley):

„Dlaczego istnieje świadomość? Ponieważ lokalno-redukcjonistyczne prawa fizyki uważane za przyczynowy opis świata, są niekompletne: potrzeba czegoś więcej, by doszło do kolapsu funkcji falowej, do pojawienia się ‘klasyczności’ w przyrodzie, do realizacji potencji stanów kwantowych”.

Czy to coś wyjaśnia? Nie, ale brzmi mądrze więc nie zadajemy dalej pytań.

Świadomość staje się tu mechaniczną przyczyną redukującą funkcje falowe.

Nie ma tu żadnych odniesień do funkcji poznawczych i afektywnych mózgu.

Nie bardzo wiadomo, co poza technicznymi problemami związanymi z zagadnieniem pomiaru w mechanice kwantowej tego typu rozumowanie miałoby wyjaśniać; na pewno nie ludzkie zachowanie, ani procesy podejmowania decyzji, ani skłonności do uzależnień, ani choroby psychiczne ...

Teorie Stappa, Penrose'a czy Hamerhoffa są spekulacjami, które przez ostatnie 30 lat nie posunęły nauki do przodu. Nie da się ich empirycznie zweryfikować, nie wyjaśniają wyników konkretnych eksperymentów ani też nie przewidują nowych zjawisk.

Wśród fizyków jest trochę zwolenników takich rozważań, odwołujących się do

problemów interpretacyjnych mechaniki kwantowej

(Hameroff, Penrose 2013), nie ma to jednak żadnego wpływu na rozwój badań nad mózgiem czy kognitywistyki. Dlatego uwagi na ten temat umieściłem w rozdziale o "manowcach umysłu".

Robert Anton Wilson jest raczej pisarzem science fiction i badaczem okultyzmu niż popularyzatorem nauki, ale napisał książkę "Psychologia kwantowa" (Warszawa: Okultura, 2008). Niestety nie ma tu żadnej realnej treści tylko pseudonaukowe spekulacje nie oparte na żadnej weryfikowalnej wiedzy. Używanie pojęć fizyki kwantowej zawsze robi wrażenie na naiwnych czytelnikach. Niestety na różnych uczelniach tworzy się studia podyplomowe w zakresie "pedagogicznych podstaw psychologii kwantowej", powstała "Kwantowa Szkoła Kreacji" i wiele innych organizacji, głoszących bardzo dziwne teorie oderwane od rzeczywistości. Zawsze dobrze jest zapytać "skąd to wiemy"?

Biocentryzm Roberta Lanza, znakomitego biologa, lansowany jest jako zmiana paradygmatu, to w zasadzie zasada antropiczna w mocnym wydaniu. Autorowi wydaje się, że to życie tworzy wszechświat, świadomość tworzy czas i przestrzeń, ramy w których się poruszamy. Dowodem na to mają być eksperymenty ze splątaniem kwantowym, które dają różne tylko z powodu zmiany "wiedzy w umyśle obserwatora" - tylko co do tego ma wiedza? To ustawienie eksperymentu wymusza określone reakcje przyrządów. Jeśli zarejestrujemy miliard zdarzeń to jaką wiedzę ma obserwator o każdym z nich? Może jedynie sięgnąć od statystycznych korelacji.

Chociaż ze spekulacji na temat biocentryzmu nic nie wynika ale

media to uwielbiają. Co może oznaczać życie poza czasem? Jeśli nic się nie zmienia to nie ma wrażeń ani myśli, jeśli coś się zmienia to można mierzyć szybkość zmian, a więc można określić czas.

Należy odróżnić spekulacje od wiedzy naukowej; spekulacje nie stają się nigdy obowiązującymi dogmatami, nauka to nie religia. W nauce nie ma dogmatów tylko najbardziej prawdopodobne modele.

Jednakże krytyka niektórych fizyków (np.

Sean Caroll, którzy upierają się, że w równaniu Diraca czy Schrodingera nie ma miejsca na oddziaływania z niematerialnym światem są też nieporozumieniem, na które mógłby odpowiedzieć już Arystoteles ze swoją koncepcją duszy jako formy, a nie substancji, albo też Eccles z pomysłem modyfikacji prawdopodobieństw. Nie na tym polega niematerialność umysłu, że dzieją się w nim rzeczy nie mające swojego odpowiednika w procesach materialnych. Informacja nie jest materią tylko formą materii, strukturą relacji pomiędzy materialnymi zdarzeniami.

Energia/masa nie ginie tylko ulega przemianom, ale struktury zawierające informację mogą ulec zniszczeniu i informacja ginie - np. białko pod wpływem

temperatury ulega denaturacji (rozrywane są wiązania chemiczne) i nie może już wrócić do swojego pierwotnego stanu i funkcji.

Fundamentalne teorie fizyki dotyczą zjawisk najprostszych, np. teoria grawitacja dała się zgrabnie zmatematyzować w postaci opisu zakrzywionej czasoprzestrzeni w Ogólnej Teorii Względności.

Nie ma jednak powodu by działanie mózgu dało się opisać jednym matematycznym równaniem.

Umysł nie jest wynikiem prostego zjawiska fizycznego, składa się na niego ogromna liczba różnych współdziałających ze sobą funkcji, wymagających wyjaśnienia.

Jedną z takich funkcji jest kreatywność, inną świadomość czy wola działania; nie można ich jednak traktować w oderwaniu od tysiąca innych funkcji, realizowanych przez mózg.

Chociaż dla wyjaśnienia natury świadomości i umysłu sformułowano kilka pomysłów odwołując się do egzotycznych teorii kwantowych nie udało się za ich pomocą niczego wyjaśnić. Co gorsza, nie definiując co dokładnie chce się wyjaśnić - czyli nie odwołując się do konkretnych zjawisk mierzalnych eksperymentalnie - nie wiadomo co te teorie miałyby wyjaśniać. Tymczasem naukowe badania nad świadomością zrobiły ogromne postępy wykorzystując zarówno neuroobrazowanie, techniki behawioralne jak i modelowanie komputerowe.

Niematerialny świadomy umysł jest złym rozwiązaniem, niezależnie od technicznych rozważań związanych z mechaniką kwantową, albowiem:

- Niczego to w istocie nie wyjaśnia, nie podaje mechanizmów podejmowania decyzji, tylko odsuwa problem w zaświaty; jak powstają tam decyzje, chęci działania, skąd się biorą? Mamy problem nieskończonego regresu i żadnego rozwiązania.

- Odczuwanie emocji, postrzeganie, pamięć wymaga zmiany, a jeśli niematerialna substancja umysłu ma ulegać zmianie, to musi to być zmiana czegoś, jakiegoś substratu - na czym więc miałaby polegać jego niematerialność? Niematerialna substancja to sprzeczność sama w sobie.

- Istnienie niematerialnego umysłu dałoby się udowodnić gdyby neuromorficzne systemy, które się obecnie buduje, nie działały z powodu braku jakiegoś magicznego składnika; na to się nie zanosi, chociaż nie mamy jeszcze modelu całego mózgu to jego funkcje i sposób działania w terminach przetwarzania informacji są coraz bardziej zrozumiałe.

- Niematerialne są idee, równania, algorytmy, relacje, informacja; chociaż ich zapis wymaga materialnego podłoża trudno kwestionować ich niematerialny charakter.

Możemy więc uznać, że materialny mózg jest substratem niematerialnego umysłu, a więc informacji, którą przechowuje i która decyduje o sposobie jego działania.

Religie mogą nadal głosić wiarę w zmartwychwstanie, odrodzenie Wszechświata po jego końcu, bo to jest całkowicie poza nauką.

Nie ma jednak sensownej koncepcji niematerialnej duszy, która by cokolwiek wyjaśniała, niezależnie od tego na jakie teorie fizyczne się powołamy.

Zasada antropiczna: Wszechświat by istnieć musi być taki, by mógł w nim powstać obserwator, bo inaczej nie można by nadać słowu "istnieje" sensu. Dlatego Wszechświat musi być tak duży i tak skomplikowany.

Dlaczego? Można obliczyć, że drobna zmiana siły oddziaływania grawitacyjnego, słabego, silnego lub elektromagnetycznego uniemożliwi powstanie galaktyk, gwiazd, węgla i innych ciężki pierwiastków, a więc życia.

Zasada antropiczna to jedna z możliwych odpowiedzi na pytanie, dlaczego własności fizyki (oddziaływania grawitacyjne, elektromagnetyczne, słabe i silne) mają dokładnie takie wartości, aby umożliwić powstanie życia.

Nie jest to chyba dobre rozwiązanie - zmiana jednego parametru może faktycznie prowadzić do martwego Wszechświata, ale są kombinacje takich stałych fizycznych, które pozwalają na istnienie życia, całe wyspy stabilności

(Alejandro Jenkins and Gilad Perez, Świat Nauki, luty 2010).

Krytyka V. Stengera pokazuje, że przekonanie o wyjątkowości naszego wszechświata jest wątpliwe. Szczegółowa krytyka argumentów dotyczących szczególnych wartości stałych fizycznych wymaga pewnej znajomości fizyki. Nie wydaje się, by ten pogląd dał się utrzymać, jak wyjaśnił to

Stenger w swojej książce - w 100 Wszechświatach z przypadkowo wygenerowanymi podstwowymi stałymi fizycznymi w 20 mogło powstać życie.

Wszechświat jest słabo przystosowany do powstania życia, na Ziemi były liczne okresy wielkiego wymierania, atmosfera słabo chroni nas przed promieniowaniem kosmicznym, zmiany klimatyczne (epoka lodowcowa) i klęski głodu, epidemie, trzęsienia ziemi, wulkany, tsunami, zabijają wielu ludzi, trudno więc uznać środowisko za przyjazne ludziom. Gwiazdy są od nas ogromnie daleko (ponad 4 lata świetlne najbliższa) a inne galaktyki ponad 2.4 mln lat świetlnych; Ziemia istnieje od 4.5 mld lat a homo sapiens od ok. 150 tysięcy, więc 0.003% historii Ziemi to czas istot ludzkich; prawie cała

materia wszechświata jest nieprzydatna do tworzenia życia; 0.000000002 część energii Słońca przypada na ogrzewanie Ziemi. Wszechświat wygląda na przeciwieństwo inteligentnego projektu podtrzymującego życie.

Mechanika kwantowa wydaje się nawet wielkim fizykom teorią dziwną i niezrozumiałą.

R.P. Feynman, The Character of the Physical Law (1967, s. 129)

"Myślę, że można bezpiecznie powiedzieć, że nikt nie rozumie mechaniki kwantowej... Nie powtarzaj sobie, jeśli tylko możesz tego uniknąć: 'Jak to jest możliwe?' ponieważ wpuścisz się w kanał, ślepą uliczkę, z której nikt dotychczas nie wyszedł. Nikt nie wie, jak to może tak być."

Większość podręczników zaczyna od postulatów mechaniki kwantowej podkreślając, że nie można ich wyprowadzić z prostszych rozważań.

W znanym podręczniku Landaua i Lifszyca (1979) znajdujemy stwierdzenie, iż stan układu kwantowego opisany jest przez zespoloną funkcję falową, zależną od współrzędnych cząstek, a kwadrat modułu tej funkcji, pomnożony przez element objętości, daje prawdopodobieństwo zmierzenia wartości współrzędnych w tym elemencie. Dalej pojawia się informacja o wartościach własnych operatorów, którym odpowiadają możliwe wyniki pomiarów wielkości fizycznych, co prowadzi do ładnego formalizmu matematycznego.

W podręczniku Schiffa (1977) są postulaty dotyczące zastępowania zmiennych dynamicznych przez operatory a wyników pomiarów przez ich wartości własne.

Większość podręczników a nawet książek filozoficznych (por. Heller 1996) na temat mechaniki kwantowej zmierza szybkimi krokami do badania struktur matematycznych nie wyjaśniając skąd się biorą i jaki jest ich związek z rzeczywistością.

- Dlaczego mamy taką strukturę teorii?

- Dlaczego funkcje zespolone?

- Dlaczego operatory a nie zwykłe funkcje, tak jak w mechanice klasycznej?

- Czemu nie wystarczy funkcja w trzech wymiarach, tylko potrzebna jest funkcja wszystkich zmiennych?

- Dlaczego nie można zmierzyć jednocześnie wszystkich własności?

- Podręczniki mechaniki kwantowej niewiele na ten temat mówią, unikając również kontrowersji związanych z procesem pomiaru.

Wszystkie koncepcje, za pomocą których tworzymy modele rzeczywistości, są jedynie konstrukcjami umysłu - co nie znaczy, że rzeczywistość nie istnieje!

Dotyczy to nie tylko sposobu kategoryzacji wrażeń zmysłowych lecz również tak podstawowych pojęć jak położenie obiektu, pęd cząstki czy jej ładunek.

Nasze koncepcje nie są elementami rzeczywistości, lecz jedynie odpowiedziami na konkretne pytania, jakie zadajemy przyrodzie, a więc wynikają z konkretnego sposobu zadawania pytań.

Struktura matematyczna mechaniki kwantowej jest prosta!

Obserwując jakikolwiek przedmiot: atom, drzewo czy człowieka, zakładamy, że da się on opisać przy pomocy zbioru własności, takich jak kształt, kolor, położenie czy masa.

Zamiast rozpatrywać dany obiekt w jego nieskończonej różnorodności – nawet w ziarnku piasku do-strzec można nieskończoność, jak powiada William Blake – rozpatrujemy niejako jego cień, rzut pełnego opisu stanu, w jakim znajduje się ów obiekt na niskowymiarową przestrzeń zdefiniowaną dla kilku wybranych własności.

Te własności nie wyczerpują oczywiście w pełni opisu danego obiektu, każdy obiekt jest nieskończenie złożony, odpowiednią reprezentacją jest więc wektor w nieskończenie wymiarowej przestrzeni.

Oznaczmy taki wektor symbolem |O> i nazwijmy go wektorem opisującym stan obiektu O (wektorem stanu).

Pojęcie reprezentacji znane jest nie tylko w fizyce kwantowej, lecz również w psychologii i kognitywistyce. Każdy obiekt opisać możemy na wiele równoważnych sposobów.

Reprezentacje możemy dobierać z punktu wygody opisu, a więc zależnie od pytań, na jakie szukamy odpowiedzi.

Dowolność wyboru reprezentacji wiąże się z możliwością przekształcania opisu tej samej informacji do różnych postaci, w praktyce mamy jednak nawet większą swobodę, zachowując tylko te cechy, które są przydatne by znaleźć odpowiedź na konkretne pytania.

Jak mamy rozumieć obiekty, które chcemy opisać? Pozornie jest to oczywiste – widzimy odrębne przedmioty, takie jak jabłka czy drzewa.

Dopóki myślimy o niezależnych kulkach, punktach materialnych działających na siebie siłami na odległość, możemy rzeczywiście z dobrym przybliżeniem tak je traktować.

Jeśli obiekt da się odizolować a jego oddziaływanie z otoczeniem jest słabe mamy pozorną niezależność i możliwość dobrego zdefiniowania tego obiektu.

Można to jednak zrobić tylko w przybliżeniu i tylko dla całkiem prostych obiektów.

Pełny opis obiektu powinien uwzględniać jego wzajemne oddziaływanie ze środowiskiem.

Jeśli na przykład interesuje nas położenie samochodu w mieście mamy tendencje traktowania samochodu jako odrębnego obiektu, którego własności określone są lokalnie, jednakże jest rzeczą jasną, że jego położenie (reprezentowane przez maksima prawdopodobieństwa na rysunku) zależy od ruchu innych samochodów i wpływa na nie. W dodatku nie możemy przewidzieć dokładnie ruchu każdego samochodu (nie mamy dostatecznie dokładnych informacji z pomiarów).

Przewidywanie położenia samochodu wymaga więc zbadania zmian w czasie funkcji zawierającej położenia wielu innych samochodów, a nie tylko jednego wybranego niezależnie od innych. Nie możemy prawidłowo opisać jednego samochodu ani człowieka niezależnie od reszty zdarzeń w świecie.

Podobnie jest w przypadku zbioru N oddziałujących ze sobą cząstek – nie wystarczy podanie rozkładu gęstości tych cząstek w trzech wymiarach, konieczny jest opis za pomocą funkcji zależnej od położeń wszystkich N cząstek i śledzenie zmiany w czasie wartości tej funkcji. Ponieważ nie mamy dostatecznie dokładnych informacji z pomiarów (i nie możemy ich mieć, bo na poziomie cząstek elementarnych dokładny pomiar zakłóca badaną wielkość) to ta niepewność będzie się ciągle zwiększać, możliwy jest więc tylko opis przybliżony, probabilistyczny.

Taką funkcję w mechanice kwantowej nazywa się funkcją falową.

Aby określić jakąś własność P danego obiektu musimy dokonać pomiaru: zmierzyć jego długość, kolor, prędkość ruchu czy położenie.

W matematycznym modelu tego procesu oznacza to konieczność zastosowania operacji odpowiadającej procedurze pomiaru własności P do wektora opisującego stan tego obiektu.

Jeśli będziemy ostrożni i nie zmienimy w czasie pomiaru naszego obiektu w wyniku operacji dostaniemy jakąś liczbę w określającą mierzoną własność i niezmieniony wektor stanu. Symbolicznie zapiszemy to jako:

P|O> = p|O>

gdzie P oznacza operację, jakiej poddany jest obiekt w stanie |O> w czasie procedury pomiarowej, a p jest w najprostszym przypadku liczbą, jaką otrzymujemy w wyniku pomiaru.

Zamiast liczby możemy otrzymać bardziej złożone obiekty, takie jak sygnały elektryczne czy wrażenia zmysłowe.

Warunkiem wykonania pomiaru jest przygotowanie układu w takim stanie |O>, by pomiar miał sens.

Napisane powyżej równanie nazywa się zagadnieniem własnym, gdyż zakładamy, że wektor stanu dla pomiaru P nie ulega w tym przypadku zmianie, czyli jest „wektorem własnym” tego konkretnego pomiaru. Taki pomiar nie zakłóca mierzonego układu.

W fizyce mierzymy takie wielkości jak masa, położenie, pęd, energię czy upływ czasu (wiąże się on ze zmianą energii).

Pozostaje jedynie kwestia techniczna: w jaki sposób dobrać matematyczną reprezentację wektora stanu, jakie własności musi mieć nieskończenie wymiarowa przestrzeń, w której ten wektor będzie określony i jak dobrać operatory reprezentujące procedury pomiaru.

Przedstawiony powyżej schemat może wydawać się nadal dziwny i abstrakcyjny, nietrudno się jednak przekonać, że jest on całkiem naturalny i wiele jego aspektów znajduje analogie w kognitywistyce.

Pomiary niekomutujące to pytania, które zmieniają nastawienie badanej osoby, czyli prawie wszystkie.

Jeśli mamy dwa pytania A i B, to zadając pytanie A zmieniamy nastawienie osoby pytanej i jej odpowiedź może wpłynąć na wynik pytania B. Kiedy wpływa? Gdy te pytania są jakoś ze sobą skorelowane. Jeśli są całkowicie na odmienny temat to pytania można zadać w dowolnej kolejności i odpowiedzi będą takie same.

Jeśli pytania są ze sobą jakoś powiązane to zadanie pierwszego i udzielenie odpowiedzi zmienia stan mózgu, drugie pytanie może nawet nie zostać dobrze zrozumiane; czy można więc mówić, że ustalone odpowiedzi istnieją w mózgu przed zadaniem pytania?

Podobnie w mechanice kwantowej nie można zadać przyrodzie dwóch pytań (wykonać dwa pomiary) jednocześnie, nie można też myśleć, że wyniki istnieją przed pomiarem, bo każde pytanie (ustawienie aparatury pomiarowej) zadawane przyrodzie ją zmienia.

Przyroda przypomina więc gigantyczny mózg a my jesteśmy jego częścią ...

Dowodem na rolę świadomości w powstaniu czasu i przestrzeni mają być eksperymenty ze splątaniem kwantowym, które dają różne tylko z powodu zmiany "wiedzy w umyśle obserwatora" (R. Lanza, Biocentryzm) - tylko co do tego ma wiedza? To ustawienie eksperymentu wymusza określone reakcje przyrządów. Jeśli zarejestrujemy miliard zdarzeń elementarnych to jaką wiedzę ma obserwator o każdym z nich? Może jedynie sięgnąć od statystycznych korelacji i stwierdzić, że założenie o niezależności pomiarów jest błędne. Wiadomo jednak, że nie da się w ten sposób przesłać sygnału szybciej niż z prędkością światła. Sam o tym wygłaszałem referaty przy końcu lat 1980.

Chociaż ze spekulacji na temat biocentryzmu i mechaniki kwantowej nic dla rozumienia natury świadomości nie wynika

media to uwielbiają.

Lanza spekuluje na wszystkie możliwe tematy, pisząc np. o nieśmiertelności poza czasem. To też oczywiście wniosek z eksperymentów nad splątaniem kwantowym z opóźnionym wyborem: najpierw mierzymy stan jednej cząstki a po krótkim opóźnieniu drugiej i nadal są skorelowane.

Skoro dla pary cząstek mamy zerowy całkowity wewnętrzny moment magnetyczny (czyli spin), a te momenty mają wartość dyskretną, np. 1 jednostkę, więc 0=+1 +(-1), wynik złożenia przeciwnych spinów w kierunku +1 i -1. Po zmierzeniu -1 dla jednej z cząstek spodziewam się +1 dla drugiej, niezależnie od tego kiedy dokonamy pomiaru (jeśli nie nastąpi jakieś oddziaływanie zaburzające stan drugiej cząstki podlegającej pomiarowi). Nie wnioskujemy stąd, że czas jest iluzją.

To jest oczywiste, ale w świecie kwantowym nie aż takie proste, bo mierzymy jedną z 3 składowych momentu magnetycznego wynikającego ze spinu, w kierunku (x,y,z). Korelacja pomiędzy pomiarem jednej cząstki w jakimś kierunku i drugiej w tym samym kierunku jest pełna, zawsze + , - lub - , +. Dziwne jest to, że korelacje mierzone pod różnymi kątami są większe niż można się spodziewać zakładając niezależność zdarzeń (maksymalne korelacje dla zdarzeń niezależnych określają

nierówności Bella).

Do zmierzenia korelacji trzeba wykonać bardzo wiele pomiarów, dopiero wtedy zobaczymy, że nadal w jakimś sensie obie cząstki stanowią pewną całość.

Formalizm mechaniki kwantowej jest dość ogólny i można go zastosować do opisu różnych funkcji mózgu bez zakładania, że są to procesy kwantowe. W takim ujęciu używa się aparatu matematycznego mechaniki kwantowej do opisu prawdopodobieństwa podejmowania decyzji czy oceny możliwości. Kwantowa kognitywistyka może więc być sensowna, chociaż wiele prac w tej dziedzinie jest kontrowersyjnych i nie wyjaśnia mechanizmów poznawczych, a jedynie dostarcza pewnego alternatywnego opisu niektórych z nich.

Zainteresowanym mechaniką kwantową polecam swój stary artykuł o synchroniczności. To są rezultaty znane od dawna, przydatne w kryptografii kwantowej, ale nie w badaniach nad mózgiem czy w psychologii, gdzie cały czas postęp jest szybki głównie dzięki możliwościom wynikającym z wszelkiego rodzaju neuroobrazowania procesów w mózgu i modeli komputerowych na poziomie klasycznej biofizyki.

Co może oznaczać życie poza czasem, o którym pisze Lanza? Jeśli nic się nie zmienia to nie może być wrażeń ani myśli, bo pojawienie się myśli to zmiana, pojawienie się wrażenia czy odczucia to zmiana. Jeśli coś się zmienia to można mierzyć szybkość zmian, a więc można określić miarę czasu.

Więcej o strukturze teorii naukowych i mechanice kwantowej w

notatkach tutaj (pdf).

M.08. Manowce filozofii

Manowce filozofii są liczne, częściej wprowadzano więcej zamieszania niż sensownych wyjaśnień.

Oczywiście wiele dyskusji filozoficznych pomaga lepiej zrozumieć problem, manowce to tylko niewielka część całości.

Skrajne wnioski wyciągnięte z tego, że możliwe są różne reprezentacje tej samej rzeczywistości.

Bazuje na tym postmodernizm wyciągając wnioski, że cała rzeczywistość jest jedynie umowna, konstruowana.

To oczywiście zupełna pomyłka, z faktu, że można coś opisywać w różny sposób nie wynika jeszcze, że obiekt nie istnieje lub że relacje pomiędzy jego stanami nie są zachowane.

Krytyka postmodernizmu napisana przez Edwarda Wilsona.

Alan Sokal, Jean Bricmont, Modne bzdury. O nadużyciach nauki popełnianych przez postmodernistycznych intelektualistów, Prószyński i Spółka, 2004.

Sprawa Sokala.

"The Open Information Science Journal", pozornie wiarygodne pismo, dało się nabrać na podobny eksperyment przez Philipa Daviesa, doktoranta z Cornell University.

Jego artykuł "Deconstructing Access Points" został napisany przez program komputerowy SCIgen z MIT. Kierownik serwisu z University of Pittsburgh zrezygnował z pełnionej funkcji.

Prowokacja Tomasza Witkowskiego w Polsce: w popularnym piśmie Charaktery opublikował popularnonaukowy bełkot, ale redakcja się tym nie przejęła.

M.09. Manowce różnorakie.

Pseudonauka może być bardziej niebiezpieczna niż zwykły nienaukowy folklor. Jest bardzo wielu

pseudonaukowców,

niektórzy z doktoratami z różnych dziedzin, a nawet z poważnym dorobkiem naukowym w swoich dziedzinach.

Popularne pisma ezoteryczne opisują rewelacyjne odkrycia i robią z nimi wywiady robiąc wrażenia, jakoby "oficjalna" nauka nie chciała uznać ich wielkich odkryć. Jednakże nadzwyczajne twierdzenia i teorie wymagają wyjątkowo dokładnej weryfikacji, a niestety tej brakuje.

Żadna z poniższych teorii niczego nie wyjaśniła i nie przyczyniła się do postępu w nauce. Oto kilka przykładów:

Lingwistyka: Marryzm w ZSRR, czyli teoria powstania wszystkich języków z prajęzyka o 4 słowach.

NLP:

Neurolingwistyczne Programowanie, to techniki komunikacji nastawione na tworzenie i modyfikowanie wzorców postrzegania i myślenia u ludzi. Dobra krytyka jest w Wikipedii.

W pracy przeglądowej "Neurolinguistic programming:

a systematic review

of the effects on health outcomes" (British Journal of General Practice, 2012) konkluzja brzmi:

There is little evidence that NLP interventions improve health-related outcomes.

W pracy

"The eyes don't have it: lie detection and Neuro-Linguistic Programming (PlLOS One 2012) 3 badania nie wykazały słuszności założeń NLP, dotyczących korelacji pomiędzy kierunkiem spojrzenia a tendencją do kłamstwa.

Poszukiwanie substancji odpowiedzialnej za umysł.

Wilhelm Reich rozwinął w latach trzydziestych XX wieku teorię

orgonu,

"podstawowej energii kosmicznej", tożsamej z energią seksualną, sprzedawał też od 1940 roku maszyny do gromadzenia orgonu.

W 1941 roku spotkał się z dwukrotnie z Einsteinem, który przeprowadził testy z maszyną orgonową, ale wyjaśnił jej działanie za pomocą konwencjonalnej fizyki.

W 1956 roku decyzją sądu zniszczono jego akumulatory orgonu a jego publikacje, pisma i notatki (ok. 6 ton) spalono; Reich zmarł w więzieniu.

Podobną koncepcję pramaterii/praenergii nazwanej eteroidem postulował w nieco przed Reichem

Franciszek Rychnowski.

Orgon nadal żyje! Stanowi podstawę dla spekulacji bioenergoterapuetów na temat siły życiowej.

Gennadij Szypow, były wykładowca fizyki na Uniwersytecie Moskiewskim, "odkrył" promieniowanie torsyjne, cztery siły inercji, antygrawitację, zasady działania latających spodków, stworzył perpetuum mobile itp ...

Fizyka tak sie nie rozwija, robi się jeden krok i weryfikuje go eksperymentalnie.

Karl Simanonok: jego teoria "endogenicznego światła", opracowana przez fizjologa, to czyste spekulacje, żaden krok nie wytrzymuje krytyki.

Albert Mahrabian, profesor psychologii, opublikował słynną regułę 7-38-55, czyli 7% to komunikacja werbalna treść wypowiedzi, brzmienie głosu to 38% a gesty i komunikacja niewerbalna to 55%. Jak można to zmierzyć? W kontekście każdej sytuacji komunikacyjnej nie może to być prawdą. Mehrabian badał osoby mówiące o swoich uczuciach, przekonaniach, postawach. Ale w jego badaniach wykazano wiele błędów. Jednak mit niewerbalnej komunikacji nadal jest powszechny.

Polski wkład do manowców nauki

Model atomu dr Gryzińskiego, znanego fizyka, który głosił "... zawracamy z błędnej drogi na jakiej znalazła się teoria atomu", czyli odrzucamy mechanikę kwantową, największą mistyfikację w historii nauki.

Gryziński był w dobrym towarzystwie, w końcu sam Einstein kwestionował mechanikę kwantową i do końca życia szukał teorii, która byłaby zgodna z realizmem i lokalnością.

Albert Einstein napisał w jednym z listów: „Myślałem sto razy więcej o problemach kwantowych niż o problemach ogólnej teorii względności.” Przez całe swoje życie Einstein kroczył samotną drogą: najpierw jako rewolucjonista, później outsider.

Proponowany nowy deterministyczny model atomu nie potrafił niestety wyjaśnić natury wiązań chemicznych pomiędzy atomami.

Prof. Włodzimierz Sedlak i jego bioelektronika, bioplazma, elektromagnetyczna natura życia. Od ponad 40 lat ta teoria słabo się rozwija, w literaturze światowej nie ma po tych koncepcjach żadnego śladu. Książki na ten temat bliższe są poezji niż naukowym rozważaniom. Podobny charakter ma psychologia kwantowa Adama Adamskiego, który opisuje "homo electronicus", bioplazmę, fale spinowe i inne zjawiska fizyczne jako podstawę działania organizmów i świadomości.

Są to spekulacje nie mające związku z biologią czy psychologią.

Fundacja Bioelektroniki im. Włodzimierza Sedlaka w 2018 roku znalazła się w stanie likwidacji.

Prof. Jan Trąbka i jego "Dusza mózgu", "Neuropsychologia światła" oraz dzieła gnostyczne daleko odbiegają od tradycyjnego sposobu uprawiania nauki.

Prof. Zbigniew Jacyna-Onyszkiewicz jego modele Boga, w tym kwantowa teoria Trójcy Świętej, która przy okazji wyjaśnia też w stylu idealizmu Berkeleya istnienie indywidualnej i zbiorowej świadomości.

Wiele bełkotu na temat mechaniki kwantowej można też znaleźć w licznych książkach napisanych przez dr Danutę Adamską-Rutkowską. Z reklamy jednej z jej książek "Autorka bestsellerów łączących naukę z tym, co niezwykłe, w swojej najnowszej publikacji ujawnia mechanizmy, dzięki którym funkcjonują takie zjawiska jak teleportacja, lewitacja, telepatia, jasnowidzenie czy telegnozja. Co więcej, udowadnia, że większość ludzi jest w stanie skorzystać z tych pozornie magicznych praktyk. Rzuca również nowe światło na bioenergoterapię i zdradza sekrety stosowania tego typu uzdrawiania." A wystarczy sięgnąć po milion dolarów od Randiego by ludzi przekonać, że to realne zjawiska a nie fantazje.

Dr Andrzej Buller i CAM Brain, opisany w książce "Sztuczny mózg: To już nie fantazje". A jednak ... miał być sztuczny kot Robokoneko w 2001 roku, ale na czym polegał pomysł budowy sztucznych mózgów?

Inżynierzy ewolucyjni podzielą między siebie zadania i będą się starali wyewoluować kolejne funkcje mózgu. Ewolucja powinna wytworzyć odpowiednie funkcje nawet bez planu budowy sztucznego mózgu. Zadziwiająco wielu ludzi wierzy w absolutną potęgę ewolucji ...

Dlaczego nie jest to dobry pomysł? Gdybyśmy dokładnie znali wszystkie funkcje to ich zaprogramowanie nie byłoby takie trudne, zapewne łatwiejsze niż wyewoluowanie.

Niestety nie znamy dokładnie funkcji i nie wiem co ewoluować, jakie potrzebne są do tego warunki ...

Hugo de Garis

nadal próbuje rozwijać takie idee ewolucyjne, ale postępu nie było widać, więc zamiast budową sztucznego mózgu zajął się w nowszych książkach straszeniem wojną z robotami.

Czym nauka różni się od psuedonauki? W ciągu 20 lat pojawiły się komputery osobiste, Internet, smartfony, wirtualna rzeczywistość, interfejsy mózg-komputer, udało się wywołać wrażenia autoskopowe ... Nadal nie działa telepatia, jasnowidzenie, antygrawitacja, latające talerze, lewitacja, teleportacja, uzdrawiające akumulatory orgonu, a wędrówka świadomości w inne światy niczego nas nie nauczyła. Co gorsze, różni bioenergoterapeuci przyczynili się już do śmierci wielu osób.

M.10. Podsumowanie

Manowce nauki i pseudonauki są liczne, tu starałem się skupić tylko na tych związanych z kognitywistyką, w fizyce ulubioną dziedziną jest podważanie teorii względności.

Nie dajcie się zwieść na manowce!

Zainteresowanie manowcami nauki to typowy temat zastępczy.

- Ludzie pozornie zainteresowani własnym rozwojem zamiast pracować nad sobą i analizować swój umysł szukają mądrości w połączeniu fizyki z metafizyką. Nic z tego nie wynika, ale uspokaja sumienie, stwarzając wrażenie, że coś dla siebie robimy ...

- Wystarczy wprowadzić jakąś ładną nazwę, np. indeks świadomości oparty na integracji informacji, by stworzyć pozory zrozumienia, chociaż nic to nie wyjaśnia.

- Mylenie modeli matematycznych z rzeczywistością--niestety możemy to zaobserwować nawet w fizyce, zwłaszcza w rozważaniach na temat początków Wszechświata.

- Trzymajmy się konkretów, hipotez, które można zweryfikować i które mogą mieć jakiś wpływ na zrozumienie świata. Niestety, nie zawsze jest to łatwe.

Przykładowe pytania, na które ten wykład powinien wskazać racjonalne odpowiedzi:

- Po czym można poznać, że pozornie obiecująca teoria zeszła na manowce?

- Czym zajmuje się psychologia głębi?

- Na czym miała polegać synchroniczność według Junga i Pauliego?

- Co to jest archetyp i co to pojęcie miało wyjaśniać?

- Czym jest nieświadomość i przedświadomość?

- Czy potrafimy opisać swoje doświadczenie wewnętrzne? Dlaczego?

- Jakie podejmowano próby opisu treści umysłu i czym się skończyły?

- Dlaczego nasze zachowanie nie da się zwerbalizować i opisać w logiczny, narracyjny sposób?

- Czym zajmuje się psychologia humanistyczna?

- Jakie poziomy wyróżnił Maslow w piramidzie potrzeb ludzkich?

- Na czym opiera się teoria Z Maslowa?

- Czym zajmuje się psychologia transpersonalna?

- Czy nauka jest "monologiczna"?

- Czy możliwa nauka translogiczna?

- Do czego może przydać się teoria chaosu?

- Co to jest teoria katastrof elementarnych i do czego się przydaje?

- Na czym polega "paradygmat holograficzny" w teorii umysłu?

- Jakie aspekty umysłu próbują wyjaśnić niektórzy fizycy kwantowi? Do czego im potrzebna jest świadomość?

- Co to jest zasada antropiczna?

- Jak interpretujemy równanie P|O>=p|O>?

- Dlaczego nie zawsze można zmierzyć dwie różne własności jednocześnie?

- Czy można powiedzieć, że własności ludzi istnieją przed pomiarem? Dlaczego?